El rol del periodismo en épocas de desinformación

Milena Álvarez | 31/08/2023

¿Alguna vez viste una noticia que luego resultó ser engañosa o a un medio desmentir información que publicó? Hoy en día, con el crecimiento exponencial de circulación de información en Internet, es cada vez más alta la probabilidad de que datos falsos lleguen a los medios de comunicación tradicionales. Si bien es cierto que las redes sociales son espacios en los que las personas pasan cada año más tiempo y su uso para fines informativos crece constantemente, los medios de comunicación tradicionales continúan teniendo un rol fundamental en proveer información a la ciudadanía. Esto nos lleva a reflexionar sobre el rol del periodismo, en la veracidad de la información que presentan y la necesidad de contar con fuentes confiables al momento de informarse.

A fines del 2022, en el programa El Pase del canal La Nación + se analizó un video de un acto del plenario de la Unión Obrera Metalúrgica (UOM) en el que la vicepresidenta Cristina Fernández estaba presente y las personas asistentes cantaban la consigna “vamos a volver”. Luego de verlo, los conductores opinaron que era incongruente pedir “que vuelva” al gobierno una dirigente que es parte de la administración actual y ocupa un rol institucional clave. El video, que fue publicado por el canal a partir de unos tweets virales, resultó ser engañoso ya que el audio estaba editado. Mediante un chequeo de fuentes se pudo corroborar que el audio original era otro.

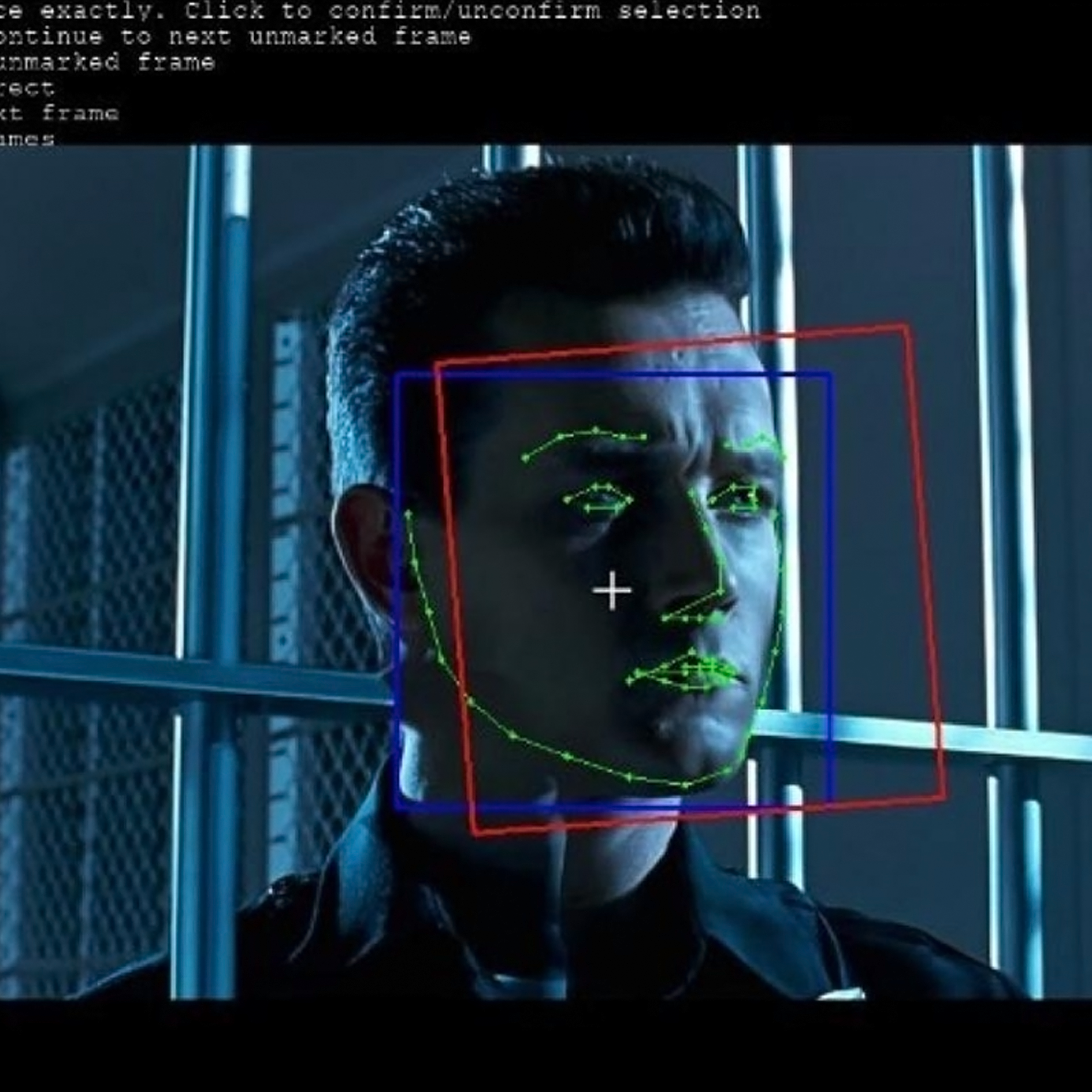

En este caso, información extraída de las redes sociales llegó a la televisión sin un chequeo previo, generando así un efecto multiplicador de la desinformación. Si bien se menciona este caso como un ejemplo, es necesario estar alerta sobre este tipo de errores porque, en un contexto en el que abundan las imágenes creadas mediante inteligencia artificial y deepfakes, los desafíos de comunicar se multiplican.

Para dimensionar el impacto que mantienen los medios de comunicación en la forma en que las personas acceden a la información en nuestro país se puede consultar la Encuesta Nacional de Consumos Culturales que indica que el 91 por ciento de la población consume televisión de aire o cable, y el 83 por ciento lo hace de manera habitual. De los tipos de programas de TV, el 70 por ciento de las personas elige los informativos. Sobre noticias escritas, la lectura frecuente se registra sobre todo en redes sociales y diarios digitales.

Contrastar las fuentes con regularidad y corroborar la veracidad de la información es una parte fundamental de la labor periodística, pero al mismo tiempo es una actividad que requiere que se le destine gran cantidad de recursos, siendo el más importante de ellos el tiempo. La novedad y la necesidad de publicar una noticia “antes que nadie” son moneda corriente en el rubro y por eso los riesgos de darle exposición a un contenido falso se multiplican.

Los desafíos de la actualidad generaron el surgimiento de un nuevo actor: las organizaciones que se dedican a desmentir contenido engañoso y a ampliar el contexto de determinadas noticias. Los fact checkers trabajan en muchos países y se encargan de salvaguardar el derecho al acceso a la información de calidad, adaptando su labor al contexto en el que están. En Argentina la organización Chequeado dobla esfuerzos en períodos electorales para resguardar el derecho al voto informado de la población.

Salvaguardar el debate democrático tiene que ser el principal objetivo del periodismo en todo momento, pero sobre todo en épocas electorales, por este motivo es necesario contar con una “caja de herramientas” que incluya medios de confianza, seguir a profesionales del fact checking y buscar información alternativa si algo genera dudas, tal como indica nuestro informe de buenas prácticas.

More

En la actualidad es claro que la participación en la vida pública no está limitada al espacio físico sino que el espacio digital se convierte también en un entorno que permite un ejercicio activo de la ciudadanía. Sin embargo, la confusión generalizada que puede generar un deep fake y las grandes cantidades de desinformación que circulan afectan la posibilidad de ejercer esa ciudadanía en internet. Tanto las personas que son protagonistas de las falsificaciones creadas mediante inteligencia artificial como aquellas que comparten esa información errónea son afectadas por un contexto que disminuye sus capacidades para generar un debate informado y que genera cada vez más desconfianza y confusión.

Según medios estadounidenses, las elecciones presidenciales de 2024 serían las primeras en estar repletas de desinformación creada con inteligencia artificial, por lo que se teme que el límite entre realidad y ficción se vuelva difuso y difícil de distinguir para las personas de a pie. Sin ir más lejos, aunque falte más de un año para el inicio de campaña, ya aparecieron los primeros engaños utilizando inteligencia artificial en imágenes, creando deep fakes y falsificaciones de voz.

En las internas estadounidenses ya comenzó la disputa y se dió a conocer un anuncio que incluye un montaje de Donald Trump muy cercano a uno de sus mayores opositores, Anthony Fauci. Estas imágenes, que son parte de la campaña de Ron DeSantis quién ya lanzó su candidatura a la presidencia, tiene la clara intención de desacreditar al ex presidente mostrando una supuesta falta de coherencia. Lo que llama la atención de este anuncio es la forma en la que presenta la información: mezclando imágenes reales con otras creadas por una inteligencia artificial.

Por otro lado, en su red social Truth Social, Trump publicó un video en el que recrea el lanzamiento de campaña que DeSantis realizó mediante Twitter Spaces, burlándose de los inconvenientes técnicos que ocurrieron. En la parodia se usó inteligencia artificial para simular las voces de personas invitadas al lanzamiento de campaña de DeSantis, entre quienes se encontraban George Soros, Adolf Hitler y hasta “el diablo”.

Tanto DeSantis como Trump son competidores para un rol de alta exposición y conocen las reglas del juego. Sin embargo, las falsificaciones no se limitan a su partido y en un entorno competitivo hay un impacto negativo cuando se acusa falsamente a una candidata o candidato, o se pone en duda su credibilidad. Al mismo tiempo, del otro lado de estas campañas de comunicación se encuentran las personas que también participan de este sistema, consumiendo el contenido y/o compartiéndolo.

Quienes comparten contenido falso no logran acceder a información de calidad y replican información dañina. Al mismo tiempo, quienes consumen el contenido deben invertir cada vez más tiempo para informarse. La necesidad de chequear en varios medios si una noticia es real o no es una práctica aconsejable en cualquier contexto, sin embargo, es poco realista pensar que todas las personas cuentan con el tiempo suficiente para hacerlo a diario.

Del lado de las empresas, podemos notar que en contextos electorales la autorregulación de las plataformas generadoras de imágenes no es suficiente, tal como se amplió en una nota anterior. En la mayoría de los casos no alcanza con la prohibición de generar imágenes de boletas partidarias o urnas, ya que cualquier imágen pueda llegar a tener un significado político, tal es el caso de Fauci mencionado más arriba.

Con la extensión de estas prácticas se degrada cada vez más el espacio cívico al no lograr unas pautas comunes en el debate en internet. ¿Cómo podemos ejercer el derecho al acceso a la información cuando tememos que toda la información que nos rodea sea posiblemente falsa? En este año electoral, pero sobre todo, para los que siguen, estos elementos serán centrales para pensar a internet como un lugar donde ejercer la ciudadanía.

More

A partir de la aparición de los primeros deep fakes sobre cuestiones políticas, los medios y sectores académicos señalaron el alto potencial que este tipo de contenido tiene para difundir desinformación en internet. Las redes sociales son un lugar en el que las personas entran a distenderse y contactar con otros, pero cada vez más se convierten en una fuente de información confiable. Un 35,8 por ciento indica que las usa para estar al tanto de las noticias y, a su vez, el tiempo de uso aumenta cada año. En Argentina el promedio diario es de 3 horas y 15 minutos (un aumento de 11 minutos en relación con 2022). Por este motivo es que se torna central conocer qué medidas toman las plataformas con respecto a la difusión de deep fakes con fines de desinformación. ¿Es posible denunciar un deep fake? ¿Las plataformas eliminan estos contenidos? ¿Cómo definen si un video es deep fake o no? ¿Qué sucede cuando el uso de un deepfake no está hecho para engañar sino con fines de sátira política?

Las grandes crisis son terreno propicio para la aparición de desinformación, por eso desde el inicio del conflicto bélico entre Rusia y Ucrania se multiplicaron los contenidos engañosos. En marzo del año pasado apareció un video en Facebook y Youtube en el que el presidente ucraniano Volodymyr Zelensky anunciaba su rendición ante Rusia y pedía a los soldados que depusieran las armas. El clip se replicó también en el sitio web del canal de televisión Ucrania 24, lo que masificó su alcance. Pocos minutos después, el mismo Zelensky publicó un video en Facebook denunciando que el contenido era falso, lo que llevó a una respuesta inmediata de la plataforma. Nathaniel Gleicher, jefe de política de seguridad de la empresa, publicó en Twitter un comunicado donde explicaba que el video había sido eliminado por incumplir su política sobre vídeos manipulados con fines engañosos.

En este caso, el alto perfil público del presidente ucraniano y la rápida respuesta tanto del gobierno como de los medios y plataformas de redes sociales permitieron que el engaño no se difunda, frenando las consecuencias a nivel bélico. A esto se suma el hecho de que el deep fake no era de buena calidad, por lo que fue cuestionado por las usuarias y usuarios rápidamente.

Como se mencionó anteriormente, Facebook dispone de una política contra la publicación de videos manipulados. Estas medidas tienen diferentes niveles de penalización. Si la publicación infringe las normas comunitarias (sea porque incluyen desnudez, violencia gráfica, supresión de votantes y/o incitación al odio) se elimina. Si no infringe las normas, la publicación es revisada por fact checkers que definen si se trata de contenido engañoso o no. Además, se reduce el alcance de la publicación y se incluye una advertencia sobre la veracidad del mismo.

Otras plataformas cuentan con políticas similares para frenar la difusión de deep fakes. Twitter elimina tweets si considera que hay peligro grave de dañar a personas o comunidades, si no es así puede agregar una etiqueta proporcionando contexto para que las personas tengan más información al definir si lo que están viendo es auténtico o falso. Las pautas de Youtube indican que el contenido engañoso, incluidos los deep fakes, no está permitido en la plataforma. En este caso aclaran que para detectarlos utilizan una combinación de revisores de contenido y aprendizaje automático, de forma tal que puedan eliminarlos rápidamente. En Tik Tok, las políticas indican que al publicar contenido generado con una IA se deben agregar términos que lo expliciten (“sintético”, “falso”, “no real” o “alterado”). El contenido impreciso o engañoso pasa por revisores independientes, es eliminado de la sección “para ti” y se sugiere a las personas usuarias que reconsideren si desean compartirlo.

El análisis de las políticas vigentes en las plataformas abre algunos interrogantes. No queda claro cómo las plataformas advierten que un contenido es una falsificación creada mediante IA. Tampoco indican si utilizan alguna de ellas para detectarlos o si lo hacen mediante denuncias de las personas usuarias. Por otro lado, en ninguna de estas plataformas hay un mecanismo directo para denunciar que un video es deep fake, por lo que debe hacerse en forma general como contenido poco preciso o engañoso retrasando posiblemente la aplicación de medidas que frenen su viralización. En Facebook y Twitter podemos encontrar una distinción sobre el contenido creado con fines de sátira o parodia ya que indican que estos no serían eliminados. Sin embargo, no mencionan la forma en la que distinguen si el fin es el hacer una crítica o si se publicó con el fin de desinformar. Esta falta de información en las políticas podría llevar a que sean removidos contenidos legítimos, generando un exceso de moderación perjudicial a la libertad de expresión.

Al mismo tiempo, el modo en el que las plataformas aplican sus políticas es desigual en muchos casos. Actualmente se pueden encontrar deep fakes en Twitter sin una etiqueta que aporte contexto, mientras que también hay casos de imágenes creadas por IA que fueron intervenidas por la plataforma (aclarando que fueron creadas mediante un software).

La disparidad al momento de implementar normas afecta a la transparencia de los procesos y muestra a las claras los problemas de la autorregulación. En el caso de Zelensky hubo un accionar eficaz que permitió frenar el engaño a tiempo, pero no conocemos si la misma suerte correrá en el caso de difusión de videos falsos sobre figuras menos conocidas.

La multiplicación de contenido engañoso circulando en redes sociales es un problema en el momento actual en el que cada vez más personas acceden a las plataformas para informarse. En estos casos, la moderación de contenidos puede ser una medida útil para frenar el alcance del contenido falso. Sin embargo, es importante que las normas se apliquen por igual a cada post, independientemente si se trata de publicaciones virales o no. Sólo de esta forma la moderación será efectiva para salvaguardar el derecho de acceso a la información de todas las personas por igual.

More

A partir del lanzamiento de ChatGPT y el gran impacto que tuvo en internet, muchas empresas proveedoras de inteligencias artificiales salieron al mercado a competir por la atención de los usuarios. Tanto es así que actualmente podemos encontrar una IA para casi todo: desgrabar audios, crear guiones, resolver problemas matemáticos e incluso crear imágenes totalmente realistas. Herramientas como Dall-e, Stable Diffusion o Midjourney son muy útiles pero también pueden ser peligrosas si se usan para generar confusión o desinformar. A partir de la aparición de IAs la forma en la que la información se produce y difunde cambió radicalmente, por lo que es momento de preguntarse: ¿Las empresas conocen los efectos que tendrá la introducción de las IA en la difusión de desinformación? ¿Qué sucede con el derecho al acceso a la información de calidad?

Durante las últimas semanas circularon por redes sociales unas fotos del Papa Francisco que llamaron mucho la atención. En ellas se lo podía ver vistiendo un abrigo Balenciaga pero con un estilo similar a su tradicional sotana. Ante el desconcierto generalizado, usuarios y usuarias trataron de buscar respuestas analizando la imágen y navegando en diferentes portales. Incluso algunas personas aconsejaron “hacer zoom a las manos” porque generalmente las inteligencias artificiales suelen fallar al crear partes del cuerpo más complejas. Pero esas recomendaciones que pudieron ser útiles meses atrás ya no lo son, el salto exponencial en la calidad de las imágenes que generan las inteligencias artificiales en la actualidad es tan grande que pueden ser difíciles de detectar hasta para un ojo experto. Después de unas horas de desconcierto y debate se conoció que las imágenes eran falsas.

Las empresas desarrolladoras de IAs generadoras de imágenes cuentan con normas de uso para limitar los efectos negativos de sus creaciones pero, ¿es suficiente? En el caso de Dall-e, la plataforma prohíbe el uso político de sus productos. Por este motivo es que no genera imágenes en contextos electorales (urnas o boletas) ni tampoco imágenes alusivas a protestas o figuras políticas. El caso contrario es el de Midjourney, que tiene unas políticas mucho más laxas y prohíbe únicamente imágenes de contenido para adultos o gore. Esta diferencia en las normas de uso es problemática al momento de pensar en la responsabilidad de las empresas sobre los productos que crean. ¿Es suficiente poner unas normas de uso genéricas sin considerar todos los usos posibles de una IA? En una época signada por la rapidez en la que se difunde la información, con poco espacio para la doble verificación sería realmente beneficioso contar con reglas claras basadas en un acuerdo básico: la desinformación afecta la calidad del debate democrático y es responsabilidad de todos limitar sus efectos.

Recientemente ocurrió otro hecho que tuvo a Midjourney como protagonista, se trata de la aparición de fotos de Donald Trump siendo arrestado que generaron alarma entre sus partidarios. Actualmente el ex mandatario está atravesando un proceso legal y, fiel a su estilo, escribió en su red social Truth Social que estaba seguro de que su arresto ocurriría pronto. En el mismo posteo convocó a sus lectores a protestar para “recuperar la nación”. A partir de este acontecimiento, un usuario de Twitter le pidió a esta IA que ilustre el suceso y publicó el resultado, que se volvió viral. Algunos perfiles con mayor alcance replicaron las fotos y generaron desconcierto entre quienes querían organizarse para defenderlo y quienes dudaban sobre si el hecho era verdadero o falso.

Tanto las fotos del papa como las de Donald Trump son ejemplos claros de la capacidad que tienen las IAs para generar confusión con tan solo pedirle que represente una situación que resulte apenas verosímil. En ambos casos las imágenes ilustraron hechos que podrían tener lugar en la realidad, lo que complejiza aún más distinguir cuándo un contenido es verídico. En determinados contextos la desinformación toma fuerza y se propaga mucho más rápido y, si sumamos el componente de que todo el mundo tiene a la mano una herramienta para generar imágenes a demanda, los riesgos de la desinformación se multiplican exponencialmente.

Por el momento las medidas implementadas por las empresas son sectorizadas e insuficientes. Midjourney, a partir de la viralización de las imágenes del Papa y de Donald Trump, decidió eliminar la prueba gratuita que permitía a las personas crear hasta 25 imágenes libres. Actualmente para utilizar esta herramienta es necesario pagar una suscripción mensual. Al mismo tiempo, varios CEOs de compañías tecnológicas firmaron una carta en la que pidieron frenar por seis meses los entrenamientos de las IAs más potentes porque no se conocen aún los riesgos e implicancias para la sociedad.

Los sucesos recientes son una señal de alerta pero también indican que es un buen momento para reflexionar sobre el futuro que queremos y entablar un diálogo entre empresas, Estados y sociedad civil de forma que sea posible alinear la actividad privada con el pleno ejercicio de los derechos humanos y pensar en un desarrollo de herramientas que no colisione con el acceso a la información de calidad.

Un futuro en el que internet esté inundado de datos erróneos y sea difícil confiar en las fuentes de información es una posibilidad real. Lo que está en juego son los acuerdos que sostienen el sistema de información y, por este motivo, las respuestas desde las empresas tienen que surgir de un debate consensuado que incluya a toda la ciudadanía y a nuestros representantes.

More

En 2018 apareció un video en el que se podía ver a Barack Obama insultando a Donald Trump. Segundos después se mostraba que no había sido el ex presidente estadounidense sino que se trataba del actor Jordan Peele que se hacía pasar por él de manera hiperrealista. Este video publicado en el canal de Youtube de Buzzfeed es conocido como uno de los primeros en usar un deep fake con figuras políticas, con el buscan demostrar que se está dando un cambio en la forma en la que fluye la información y que es necesario estar alertas, ya que no todo lo que se ve en Internet es real.

Los deep fakes son videos creados o modificados mediante un software que, aplicando técnicas de deep learning, permiten crear imágenes falsas de forma realista. Si bien existen otras formas de manipulación de video, tales como la edición que incluye cortes de imagen, distorsión en la velocidad y cambios en el audio, sólo puede llamarse así a aquellos creados mediante softwares.

Los usos que se le dan a los deep fakes son múltiples, algunos más riesgosos que otros. Es posible encontrar contenido que entra en la categoría de entretenimiento y humor, tal es el caso de cuentas en redes sociales como @deepfakesar en la que se publican videos de este tipo sobre celebridades. Otros usos posibles, y menos inocentes, tienen que ver con la propagación de desinformación que pueden acarrear consecuencias políticas y también afectar el pleno ejercicio de derechos de la ciudadanía.

Este tipo de videos afecta la calidad de la información que circula en internet, pero sus efectos perniciosos se extienden mucho más allá. Un entorno en el que no se puede distinguir lo real de lo falso genera una pérdida de confianza en las instituciones y en Argentina se trata de un problema que preocupa a la población. Según la encuesta Edelman Trust Barometer del 2022, un estudio representativo de 28 países que se realiza hace más de 20 años, ante la afirmación “me preocupa que la información falsa o las noticias falsas sean utilizadas como arma” el 76 por ciento de los encuestados a nivel global dice estar de acuerdo. Si miramos solamente las respuestas de Argentina, ese porcentaje asciende a un 81 por ciento.

Los deep fakes además puede usarse para interferir en las campañas electorales y permitir la difusión de ataques personales y discusiones que son secundarias en relación a los temas que deben tratarse en campaña: las políticas que le importan a la ciudadanía. No son desdeñables los efectos a nivel personal que tienen este tipo de campañas de desinformación. Fueron sonados los casos de Nancy Pelosi, presidenta de la Cámara de Representantes de Estados Unidos, y de Patricia Bullrich, ex Ministra de Seguridad de Argentina. Ambas figuras sufrieron intentos de desprestigio de su imagen personal a partir de la difusión de videos alterados en los que parecían estar bajo los efectos del alcohol. Esto llevó a que se hable en los medios sobre su vida personal y no sobre las políticas que estaban impulsando en esos momentos.

Además de los efectos en la imagen pública de funcionarias y funcionarios, los deep fakes pueden generar alteraciones en la opinión pública. Las campañas de desinformación pueden utilizarse para afectar la imágen que la ciudadanía tiene de un partido o gobierno, o para mejorar la opinión que la ciudadanía tiene del mismo. Un caso reciente se dio cuando aparecieron vídeos como publicidad en Youtube en el que presentadores creados mediante un software daban noticias positivas (aunque poco precisas) sobre la economía en Venezuela, para promover una opinión favorable al gobierno.

Todos estos efectos conllevan también un riesgo importante, que es el aumento de la polarización política. Si bien un video puede ser desmentido, este tipo de contenido no se difunde en un contexto aislado. Debido a la lógica algorítmica de las redes sociales, es probable que un deep fake llegue a personas que tienen un esquema de pensamiento afín a ese contenido y, por ende, no cuestionen la veracidad del video. La microsegmentación, por un lado, y el efecto “cámara de eco”, por el otro, posibilitan que el contenido de desinformación circule por internet y se multiplique por cuentas que comparten y difunden, de manera casi invisible para aquellos que no siguen dichas cuentas.

En tiempos de campañas electorales como el que tendremos este año en Argentina, los contenidos engañosos representan un peligro mayor porque puede afectar a la confianza en el proceso electoral, lo que a su vez puede generar cuestionamientos a los resultados electorales. Si los ciudadanos y ciudadanas no confían en que se están haciendo esfuerzos para cuidar la integridad de los resultados electorales se pueden desatar manifestaciones y ataques directos a la democracia.

More